杨杰 博士 Yangjie , Ph.D.

人工智能驱动的闭环神经调控算法与芯片

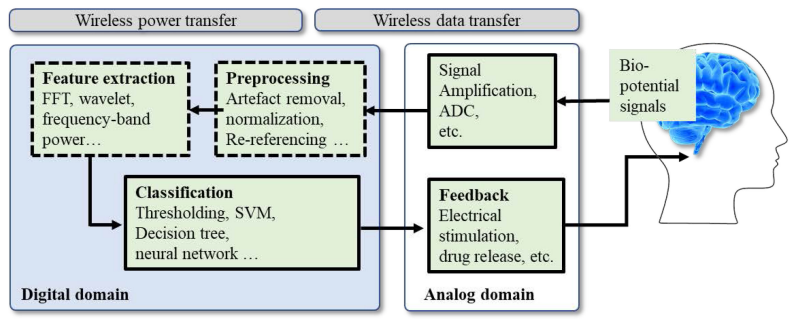

闭环神经调控系统通过实时监测大脑神经活动,检测与病理状态相关的信号特征,并按需输出神经刺激,实现精准、个性化的治疗方案,是神经调控的重要发展方向。然而,现有的芯片难以同时满足生物信号特征提取的算力与功耗约束,导致当前设备治疗效果有限、续航能力不足。

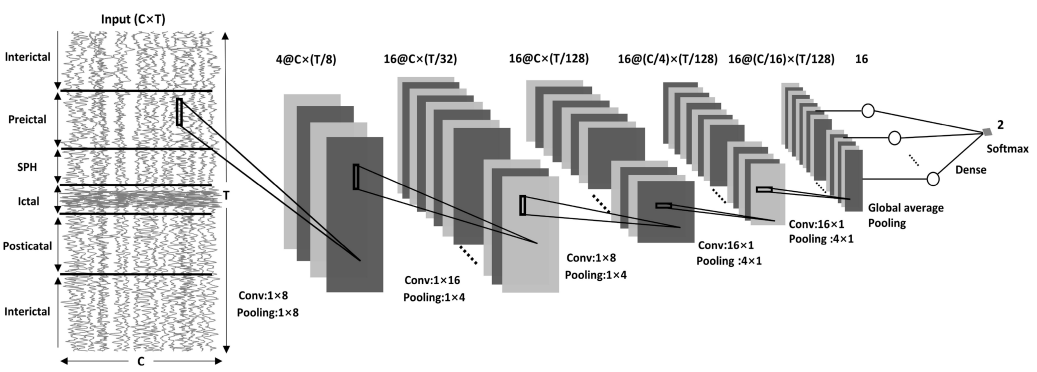

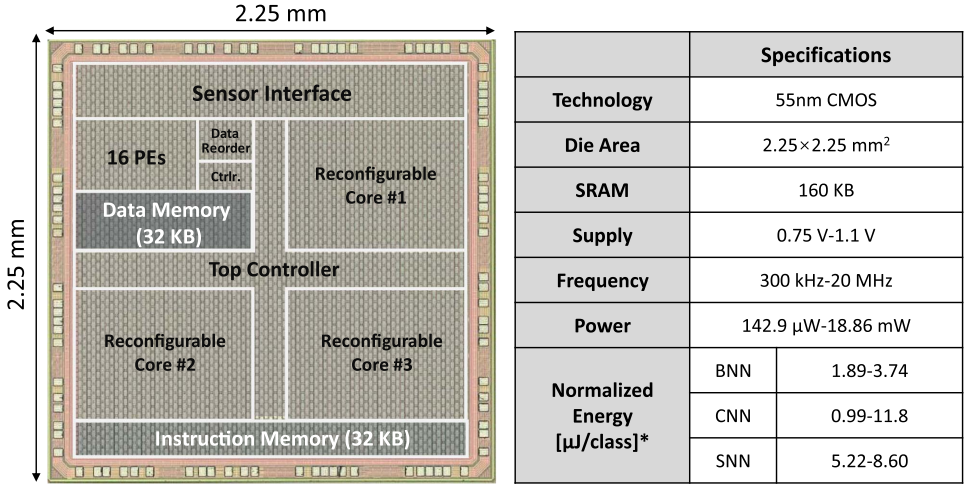

为此,我们提出在片上集成微瓦级(μW)低功耗神经网络以实现精准闭环调控的路径[TBioCAS'20, TCAS-II'22]。我们系统地探索了基于 CNN[AICAS'20, AICAS'21]、BNN[BioCAS'20] 和 SNN[ISCAS'21] 的神经信号处理算法,取得了优于传统方法的分类性能。通过结合网络结构搜索、剪枝与量化等技术,成功将模型规模压缩至 100KB 以下[TBME'21]。

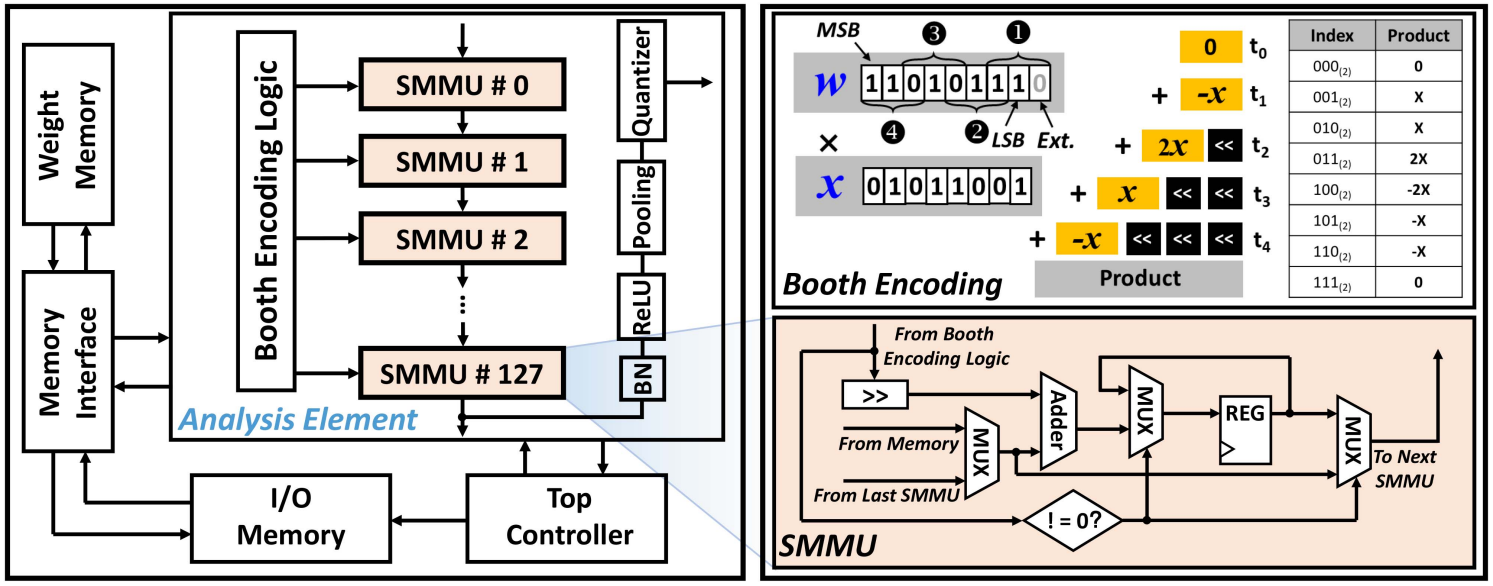

在算法基础上,我们进一步设计了支持 CNN/SNN/BNN 的可重构低功耗信号处理芯片[TBioCAS’23],采用事件驱动架构,实现了 μW 级能耗下的高效信号处理与标志物检测。为实现患者个性化,我们开发了支持直接反馈对齐机制的片上训练芯片[TBioCAS'24],在小样本在线学习条件下识别准确率进一步提升。我们最终总结出一套算法-芯片协同设计流程,系统阐述于 [Front. Neurosci.'24]。

在神经信号建模方面,我们提出基于 GAN 的数据增强方法[TBME'22]和基于知识蒸馏的跨个体训练策略[JNE'22],分别用于解决脑电数据稀缺与分布不均问题。为利用大量未标注数据,我们设计了 Fourier 掩码自编码驱动的神经信号预训练框架 Neuro-BERT[JBHI'24],显著提升了下游神经分析任务的性能。

此外,我们将疾病检测从传统二分类任务拓展为概率预测,并通过模型架构改进降低预测延迟[Expert Syst. Appl.'24],并融合多模态视觉信息辅助癫痫发作检测[ECCV'24],提升系统的临床可用性与泛化能力。

类脑计算芯片与系统

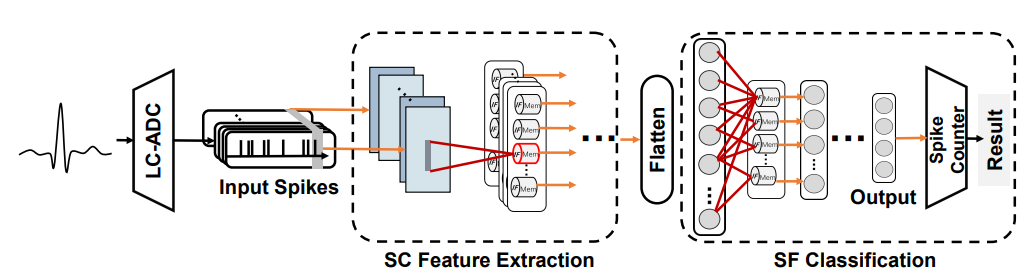

用于脉冲神经网络(Spiking Neural Networks, SNN)计算的类脑处理器在能效与性能方面显著优于传统处理器,尤其适用于对功耗敏感的边缘计算系统。我们基于类脑计算技术,开发了一系列低功耗生物信号处理应用,包括 ECG 信号处理[ISCAS'22]、癫痫信号分析[ISCAS'21]、新型脉冲编码机制[ISCAS'23],并提出了面向通用生物信号的类脑计算框架[Front. Neurosci.'23]。此外,我们研发了支持片上学习和多模态处理的可重构类脑芯片平台[ISCAS'22, ASSCC'22, TBioCAS'23],满足了植入式与穿戴式边缘设备对超低功耗与实时处理能力的双重需求。

为支撑更大规模、更复杂的类脑计算任务,我们研究了多核类脑处理器中的低延迟、低功耗路由协议与片上通信机制[AICAS’23]。针对大规模脉冲神经网络部署所面临的数据访存瓶颈与稀疏性导致的吞吐率下降,我们提出了具备非结构化稀疏感知与高度并行计算能力的类脑芯片,实现了 0.078 pJ/SOP 的超高能效[CICC'24],并支持深度 SNN 与脉冲 Transformer 网络的加速推理[JSSC'24]。

在“脑科学与类脑研究”重大科技项目支持下,我们正围绕类脑芯片、算法模型与软件工具链展开协同开发,致力于将类脑软硬件系统应用于无人车、机器人、无人机等高能效场景,加速类脑智能技术的实用化落地。

高通量侵入式脑机接口芯片与系统

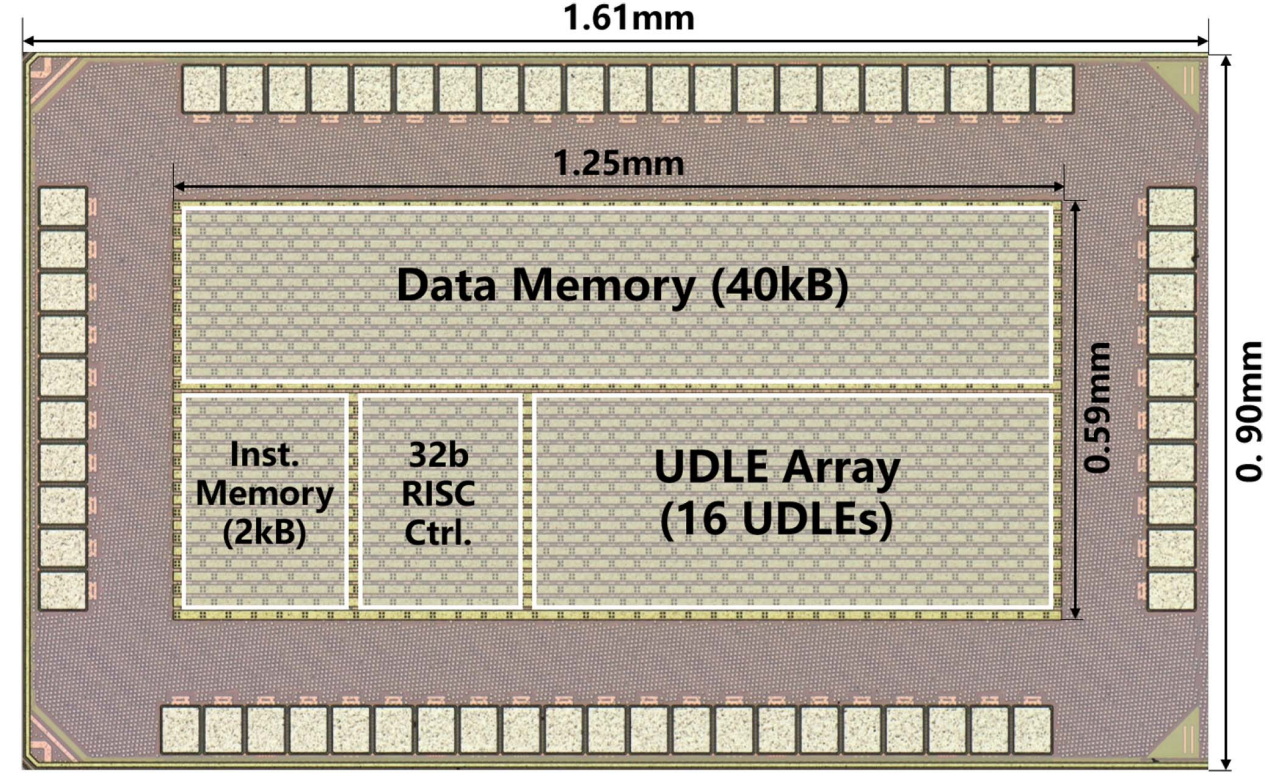

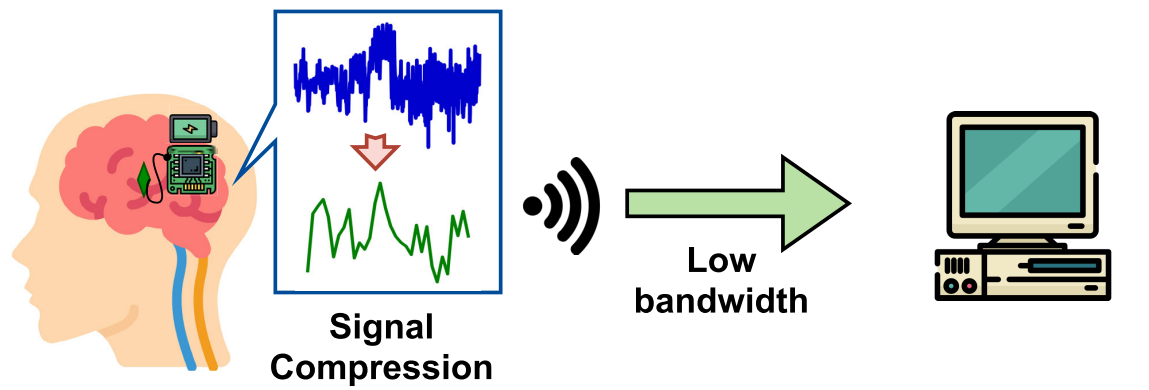

侵入式脑机接口通过在大脑与外部设备之间建立直接、高效的神经信息通路,是一项极具前景的前沿技术。其中,脑机接口芯片作为核心组件,需要在极低功耗与小面积条件下实现成百上千通道的神经信号采集与传输,设计挑战极大[TCAS-II'22]。针对高通量数据传输带来的系统功耗瓶颈,我们采用压缩感知与人工智能算法,实现了16倍低损压缩率[TNSRE'23],并通过软硬件协同设计将该方案部署于片上低功耗平台[TBioCAS'23]。该方案即使在蓝牙等低功耗无线链路下,也可支持百通道神经信号的实时传输。

在此基础上,我们进一步集成了事件驱动采样机制[APCCAS'22],结合尖峰电位识别实现超过百倍的数据压缩[AICAS'23]。同时,我们还开发了基于 IR-UWB 的无线通信模块[BioCAS'24],有效提升了跨皮肤数据传输的能效与带宽利用率。

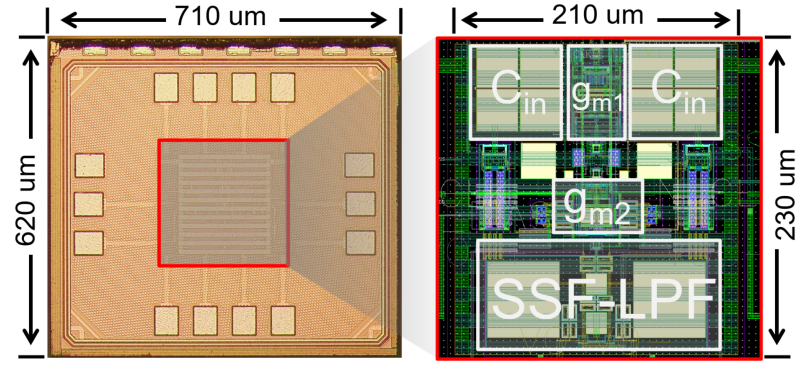

为突破面积限制、提升通道密度,我们设计了基于交流耦合斩波稳定结构的超小型低功耗前端放大器(面积 0.048mm2,功耗 2.47μW),具有可配置的截止频率与极低输入噪声(1.7μVrms)[TBioCAS'23]。通过整合快速时分复用、片上事件驱动采样与高效无线传输技术,我们在 40nm 工艺下实现了每通道面积 0.0032mm2、功耗仅 1.38μW 的神经信号记录芯片[CICC'24],为构建超高密度、低功耗的侵入式脑机接口系统奠定了硬件基础。

依托“2024 浙江省尖兵研发攻关计划”项目,我们已完成数百通道信号读出芯片、脑机接口实时串流与解码平台的开发,当前正在推进脑机接口微系统集成与动物实验验证。

侵入式脑机接口汉语解码

将脑电信号解码为语音或运动控制信号,是脑机接口技术中最具挑战性的方向之一,尤其对于帮助中风或渐冻症等重度语言障碍患者恢复沟通能力具有重大意义。目前,全球仅有少数研究团队实现了对字母语言(如英语、荷兰语)的脑电解码,而针对中文这一音节文字系统,尚缺乏完整的侵入式脑机接口解码解决方案。

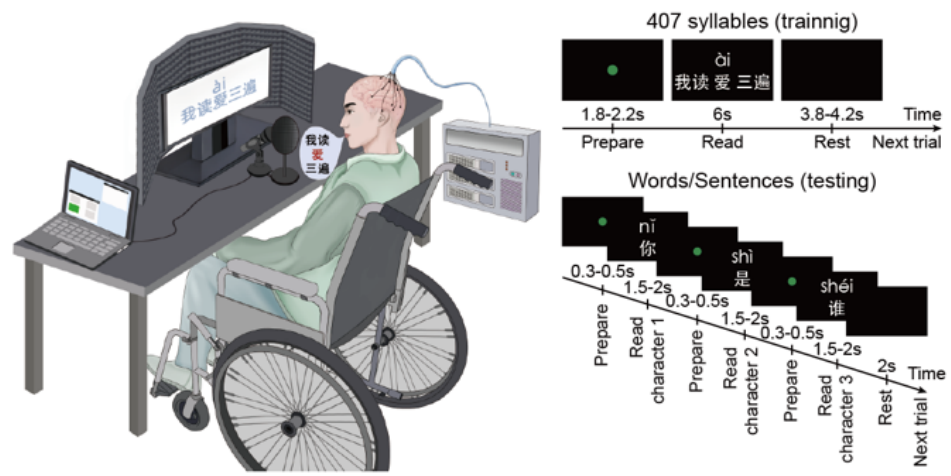

为填补这一空白,我们构建了全球首个专门面向汉语的侵入式脑机接口解码系统,能够将与语音相关的立体脑电图(sEEG)信号直接解码为完整的中文句子,具备覆盖全部汉语发音的能力。该系统以汉语拼音的三个基本要素——声母、韵母和声调——为切入点,设计覆盖 407 个音节的语料库,并同步采集语音和脑电信号,构建了超过 100 小时的中文语音-sEEG 数据库。基于该数据库,我们分别训练了三个人工智能模型对声母、韵母和声调进行独立解码,并通过语言模型融合各个要素,结合上下文语义生成完整句子。

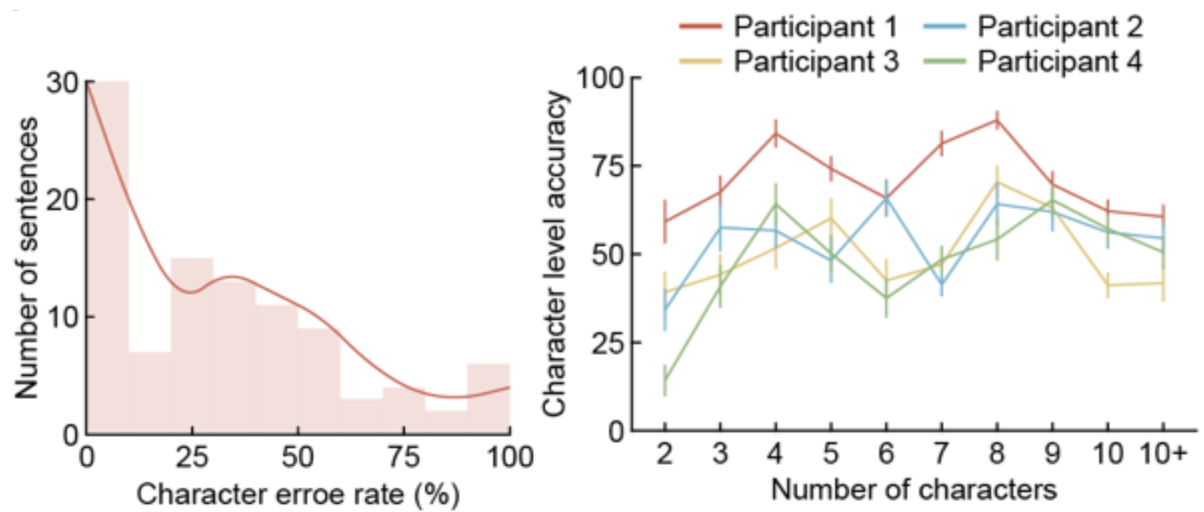

在超过 100 组随机交流任务中(字数范围 2–15 个字),所有参与者的字符错误率中位数平均为 29%,部分参与者的句子解码准确率可达 30%。相关成果2023年在[bioRxiv'23]以预印本形式发表,2025年正式发表在[Cyborg Bionic Syst.'25]上。为进一步应对跨个体数据异质性问题,我们引入了同质性-异质性分离的解码策略,利用共享码本提取不同个体间相同脑区的共性声调编码模式,结合个体私有码本捕捉个体差异,显著提升了解码准确率[ICLR'25]。

在此基础上,我们还开发了具备在线实时解码能力的脑-汉语解码系统。该系统采用轻量级神经网络构建流式推理架构,具备每秒超过 200 次推理能力,端到端解码延迟低于 10 毫秒,可实现每分钟 30 个汉字的连续解码。同时支持快速模型训练、部署和个体化校准,具备良好的临床应用潜力。

s基于神经形态处理和光遗传的视网膜假体

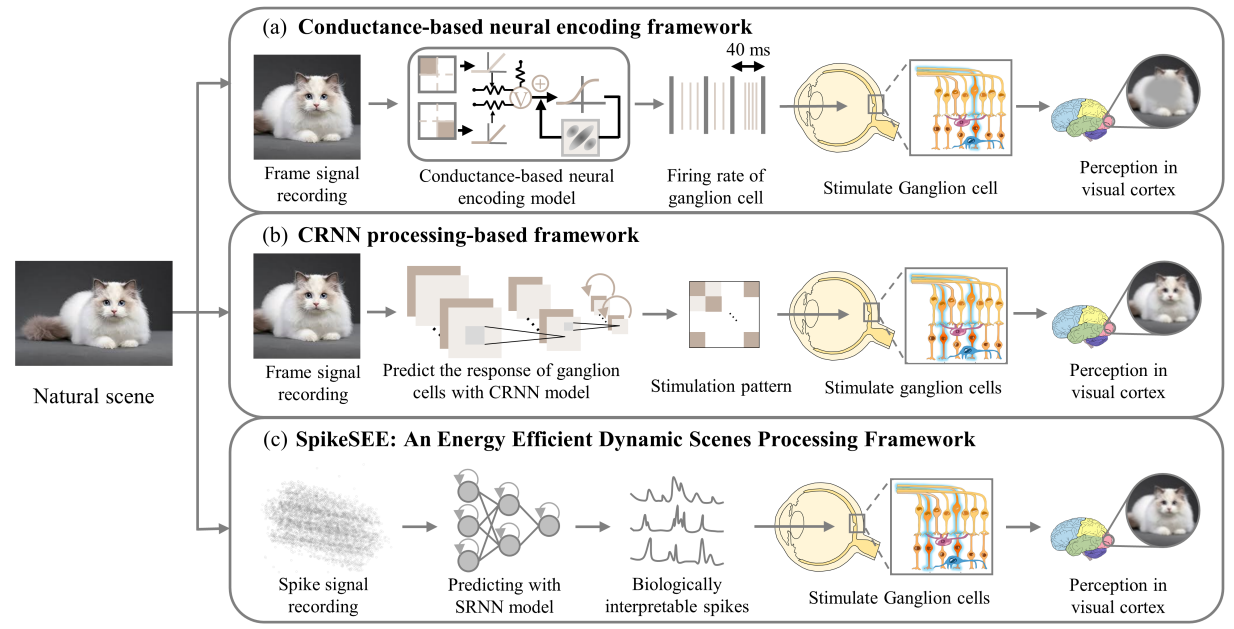

视网膜假体有望帮助患有严重年龄相关性黄斑变性(AMD)或视网膜色素变性(RP)的患者恢复部分视力。传统假体主要通过将光信号转换为电刺激,模拟视网膜细胞活动来重建视觉感知,其中光信号的处理机制对视觉恢复效果具有决定性影响。我们首先综述了当前主流视觉恢复系统中采用的信号处理策略[JNE’23],并提出一种仿生类脑视觉假体架构:利用动态视觉传感器(DVS)进行脉冲编码,再通过类脑处理器进行事件驱动计算。该架构能生成与真实视网膜高度一致的脉冲模式,同时具备极低功耗,适用于穿戴式与植入式应用场景,相关成果作为封面论文发表于[JBHI'22]。

在此基础上,我们进一步引入尖峰循环神经网络(S-RNN)提升功能仿真精度,使输出脉冲序列与真实视网膜记录信号之间的皮尔逊相关系数达到 0.93[Neural Netw.'23]。同时,构建了一个端到端类脑视觉处理框架,集成视网膜神经网络、光幻视模型与初级视觉皮层网络,其预测放电率与正常神经元反应的相关性达 0.78[ICLR'24]。

目前该方向正处于由理论算法向实验验证的关键阶段。我们已完成标准化动物行为学范式的设计与实验平台的搭建,计划于 2025 年底前通过多维度行为学指标体系对视觉假体算法进行系统评估,为推动类脑视觉重建技术的临床应用奠定基础。

高动态图像处理算法与芯片

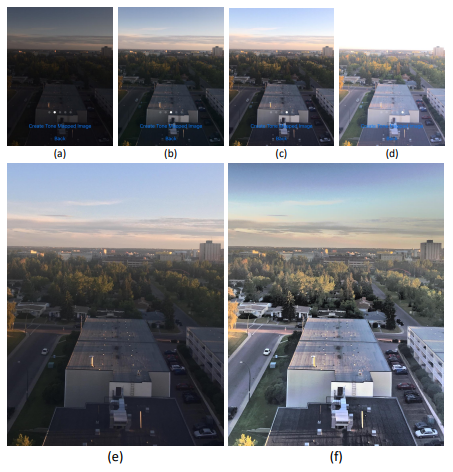

人眼可以同时感知极强与极弱的光线,动态范围超过 120 dB,而现有图像传感器的动态范围通常仅为 60–70 dB,难以覆盖复杂自然场景的亮度跨度。为弥补这一差距,我们构建了面向高动态场景的多曝光图像数据库[arXiv'21],并提出了基于多尺度、多曝光融合的图像重建算法[AVSS'17]。该方法通过对同一像素在不同曝光和尺度下的映射值进行融合,有效保留了明暗区域的细节信息。

进一步地,我们引入积分直方图与引导滤波器以提升图像质量,使得高动态场景下的极亮与极暗区域细节得以清晰呈现[CAMSAP'17, arXiv'21]。该算法已在 展示页面中公开,并在移动端 GPU 上进行优化部署,实现了在手机平台上的高效实时运行[arXiv'21]。

为了进一步增强图像细节表现,我们基于拉普拉斯金字塔将图像分解为多个尺度层级,并引入神经网络对不同尺度下的纹理进行增强,再通过重构优化后的金字塔恢复高动态图像。该方法支持根据纹理尺度权重调整整体细节强度,获得更优的视觉效果[arXiv'21],相关算法效果展示详见 展示页面。

此外,为在低成本图像传感器中实现高动态图像重建,我们还设计了两种硬件友好型算法:一是基于局部映射策略的 HDR 处理算法及其 FPGA 实现[EL'18];二是基于尾数-指数表达的全局图像压缩算法与硬件结构[TCAS-II'19],为嵌入式 HDR 图像处理提供了高性价比方案。

人工智能视觉芯片

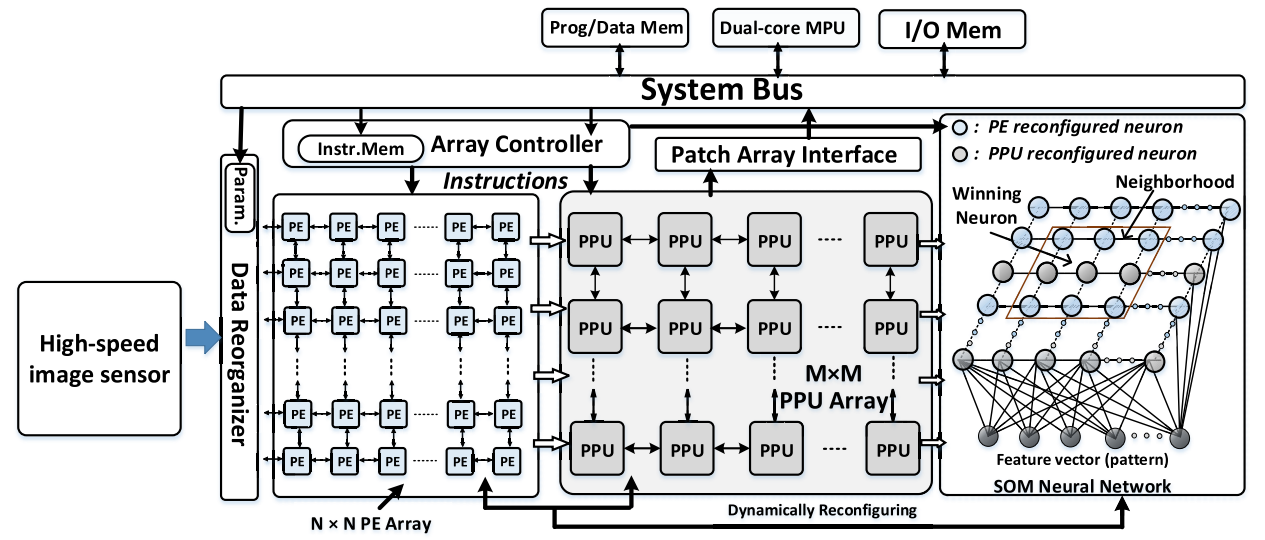

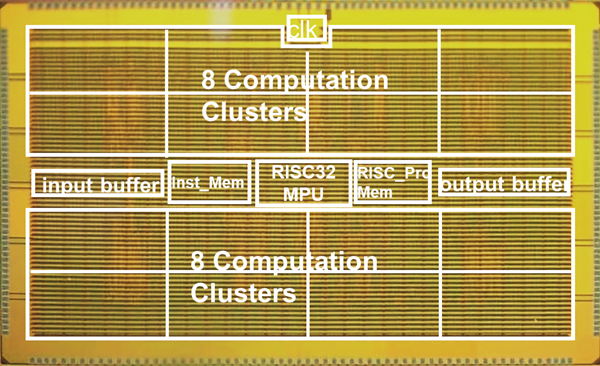

视觉芯片旨在模拟人类视觉系统的信息处理机制,以实现或超越人类视觉在目标识别、跟踪等任务中的功能与性能,广泛应用于自动驾驶、安防监控、机器人等领域。我们研发了国内首款千帧速率(1000 fps)高速视觉芯片[JSSC'14],在高帧率下实现了低延迟的图像特征提取与分类。为解决目标遮挡、形变等问题,我们进一步设计了具备像素级与区域级特征处理能力的异构视觉芯片架构[EL'14, TCSVT'18],并配套开发了对应的特征提取算法[EL'14, EL'16]。通过芯片-算法协同设计,我们实现了在 1000 fps 情况下目标的稳定跟踪,具备良好的遮挡鲁棒性[TSMCS'16, Sci. China Inf. Sci'17]。

自 2015 年起,我们率先将卷积神经网络(CNN)架构引入视觉芯片设计,替代传统区域处理方式,实现了更智能的视觉特征提取与目标识别。该视觉处理器在 65nm CMOS 工艺下流片,运行频率为 200 MHz,峰值算力达 413 GOPS,支持多类人工智能视觉任务,包括人脸识别与目标检测[Infrared Laser Eng.'20]。该芯片被成功应用于高速遥感图像处理任务[J. Infrared Millim. Waves'19],并成为中科院半导体所后续多款视觉芯片[TCAS-II'22, JSSC'23]的重要技术基础。

视觉芯片的发展本身便源于早期的神经形态计算理念,而我在博士期间所从事的视觉芯片研究,为我后续在类脑计算芯片与人工视觉系统(如视觉皮层解码与视网膜假体)方面的研究奠定了坚实基础。该技术路径自图像感知与特征提取起步,逐步拓展至支持脉冲神经网络计算的类脑处理器,最终发展为面向多模态视觉信息处理的智能系统,构成了我当前类脑计算研究的主要方向。